El 14 de marzo no es solamente un día para recordar la existencia de Pi, la constancia de Arquímedes que describe las veces que el diámetro de una circunferencia cabe en su perímetro.

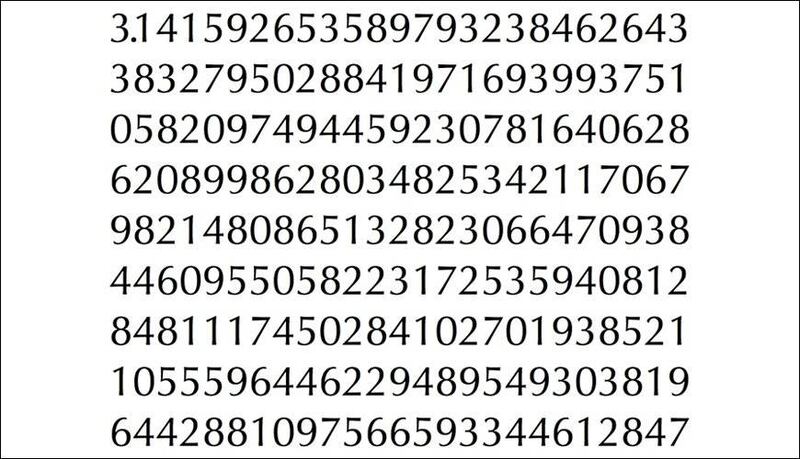

Desde hoy, podemos agregar a este día un récord bastante interesante: Google uso el poder de la nube para calcular 31 millones de millones de decimales de Pi (π * 1013) cimentando el logro en el libro de los récords Guinness y superando el anterior logro -22,4 billones de dígitos- logrado el 2016.

Una desarolladora de la empresa de Sundar Pichai llamada Emma Haruka Iwao logró tamaña tarea usando y-cruncher, un programa de benchmark usado para probar cuán rápido una máquina puede calcular π y otras constantes, usado regularmente para probar la potencia de avanzadas máquinas de cómputo.

Lo interesante del experimento es que el programa usado es totalmente escalable, por lo que sólo era necesario llevarlo a la infraestructura de Google Cloud y esperar los resultados.

Una carrera muy especial

Desde el comienzo de la humanidad, π ha sido objeto de cálculo y sus décimas irracionales han sido estudiadas por siglos. De hecho, muchas aplicaciones de ingeniería o ciencia precisan exactitud de esta constante, aunque nunca más allá de un centenar de dígitos.

Sin embargo, desde el año 2009 la constante de Arquímedes se ha vuelto famosa en los círculos matemáticos por el problema que representa calcular millones de decimales no periódicos. Científicos del área de la computación lo usan para probar supercomputadores, y matemáticos para competir entre ellos.

Uno de los algoritmos más rápidos para el cálculo de la constante -conocido como el algoritmo de Chudnovsky- indica que el tiempo y los recursos necesarios para calcular más decimales se incrementan más rápidamente que los dígitos mismos, por lo que el riesgo de perder el cálculo o fallar se hace cada vez más grande conforme más pasa el tiempo.

Los datos duros

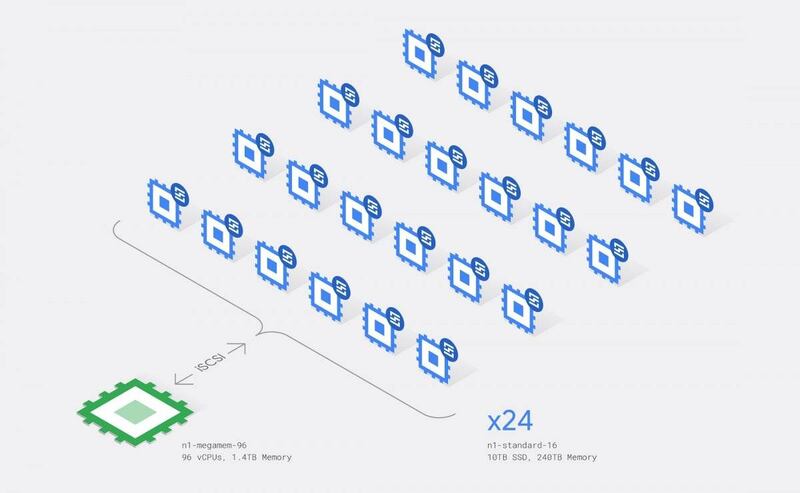

La investigadora a cargo del experimento señala que el Compute Engine de Google y los 25 nodos usados para ello estuvieron en marcha durante 111 días, tiempo en el cual Google Cloud implementó miles de migraciones en vivo sin impactar el proceso de cálculo.

Los detalles de los equipos usados son de otra dimensión: 96 vCPUs Intel SkyLake con 1.4 TB de RAM en total, además de 240 TB de discos duros SSD persistentes. El I/O de los discos es particularmente impresionante: 9.02 PB (sí, petabytes) de lectura, y 7.95 PB de escritura.

Todo esto sobre AVX-512, una infraestructura que soporta instrucciones de 512 bits sobre una arquitectura x86, un tipo de computación que está muy lejana a nuestros procesos comunes de cómputo.

Te podría interesar: